В статье разберем вопрос, как бороться с ботами на сайте и сократить количество отказов в Яндекс-метрике. Всех ботов нам не победить, это невозможно. Но кое-что сделать можно.

Оглавление

Как боты влияют на SEO-показатели?

Как сказал дед Миша (под псевдонимом Бом-Бом) - а знаешь как? Вот сегодня значит ясно, да? Значит завтра будет бом-бом. Понял, нет?

И эти мудрые слова как нельзя лучше подходят к нашей сегодняшней проблеме. Сегодня пришли боты и сделали нам отказ на сайте, а завтра Яндекс сделает нам Бом-Бом – понизит в поисковой выдаче.

С этим бороться вполне реально, но вот только не на все сто процентов. Зарубежных ботов, которые приходят из-за бугра, победить можно. А с российскими, я пока способа не придумал. Так как сайт ориентирован на аудиторию из России, то я пропускаю таких ботов.

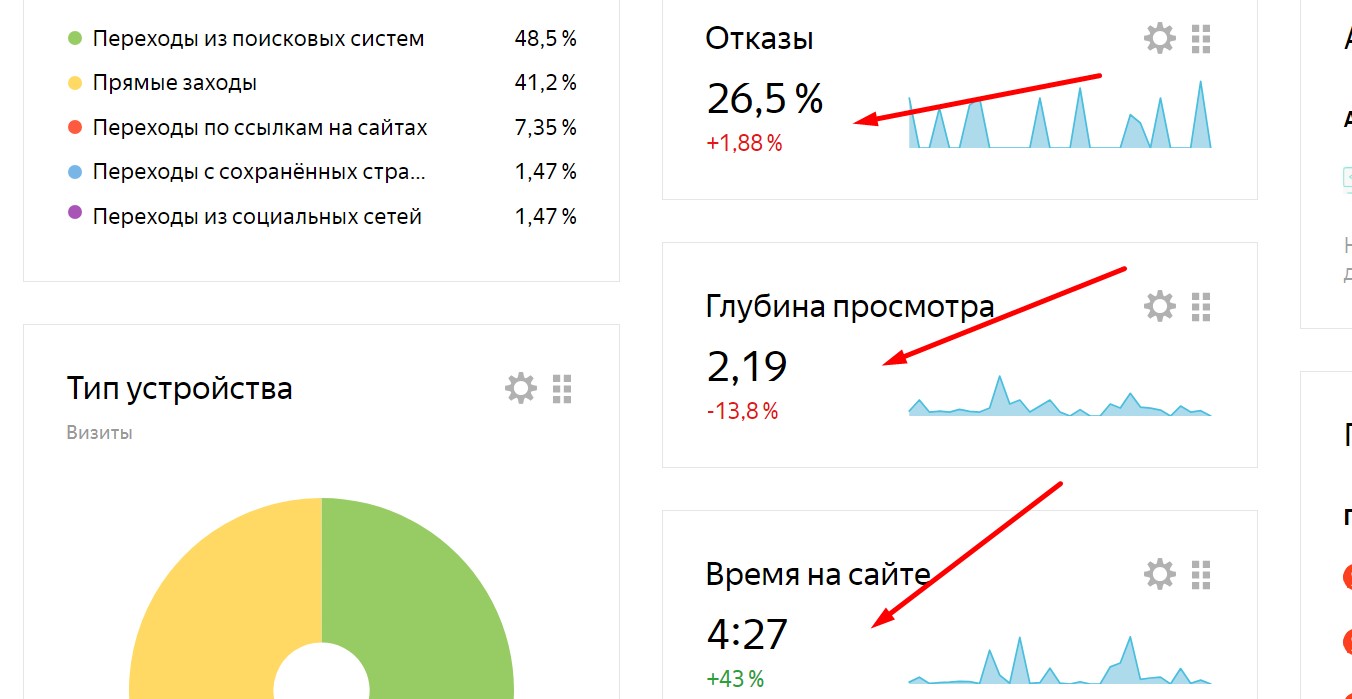

Плохие боты влияют в негативном ключе на отказы, глубину просмотра и время нахождения на сайте. Но это видимые причины в яндекс-метрике.

А есть невидимые причины – влияние на поведенческие факторы. Чем больше отказов создаются на сайте, тем хуже поведенческие факторы вашего сайта. Есть в Яндексе поисковый робот, который изучает поведенческие свойства новых сайтов – это однорукий бандит. Он подбрасывает в выдачу новые сайты, изучает их ПФ. Если люди на сайтах чаще задерживаются, то сайты останутся в ТОП-30. В противном случае их выкинет за ТОП-30.

Цели ботов на сайте

Я делю на несколько подвидов ботов, заходящих на сайты: поисковые роботы, парсеры, ботнет-сети, накрутчики, скрутчики.

- Поисковый робот обращается сначала к robots.txt, лежащему в корне сайта. Там он смотрит, куда ему можно заходить – а куда нет. Затем обращается к sitemap.xml – вашей карте сайта. Она работает, как путеводитель по Вашему сайту. Поисковый робот выполняет важную функцию – проводит ранжирование и индексирование Ваших страниц для того, чтобы они попали в выдачу Яндекса или Гугла.

- Парсеры – это программы, которые заходят на Ваш сайт с целью извлечь необходимую информацию в свою базу данных. Такие программы могут создать Вам неприятности в виде перегрузки сайта. И то при условии, что парсер делал криворукий программист, который после каждой скаченной страницы не разрывает соединения с сайтом. Некоторые сайты ставят защиту от парсинга, поэтому приходится делать задержку в парсере на 10 секунд, чтобы не быть забаненным по ip-адресу.

- Ботнет-сети – это программы, которые устанавливаются на зараженные вирусом компьютеры. Эти боты подключаются к сайту с разных источников, не разрывая соединения с Вашим сайтом. Идет перегрузка сайта, а затем он прекращает свою работу. Кстати, если у парсера убрать функцию разрыва соединения в цикле обхода, то он становится ботнет-сетью. Могут работать через прокси-серверы.

- Накрутчики – применяются черными SEO-специалистами. Они имитируют поведенческие факторы пользователей на сайте. Правда Яндекс научился различать накрутку от реальных пользователей и если увидит, что на вашем сайте идет накрутка ПФ, то понизит ваши позиции без объяснения причин.

- Скрутчики – это боты, которые наоборот скручивают поведенческие факторы на сайте. Они заходят на сайт и менее чем через 15 секунд выходят, делая в Яндекс-метрике отказ.

Я Вам расскажу способ, как бороться с двумя последними.

Как бороться с ботами?

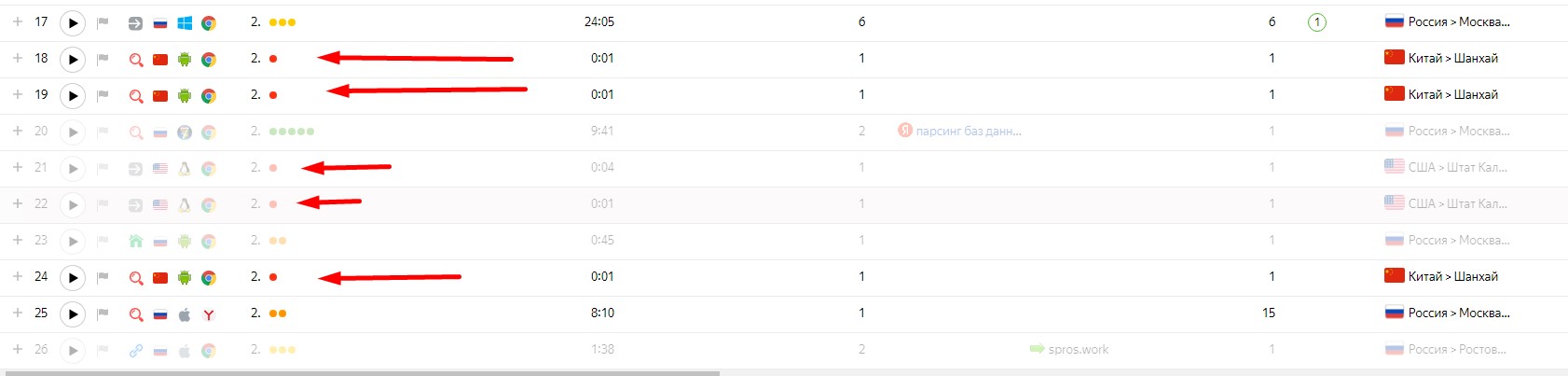

Скрутчики ПФ – это боты, которые скручивают поведенческие свойства сайта. Накрутички – наоборот. Именно их Мы видим в метрике Яндекса. И нередко они приходят из США или Китая.

Есть нехитрый способ для борьбы с такими ботами – проверять по ip-адресу, когда они заходят на страницу. И если бот из Российской Федерации, мы его на сайте оставляем. Да, он может сделать отказ – только вот иностранные боты не пройдут на сайт. В коде страницы, прямо перед счетчиком Яндекс-Метрики рекомендуется установить следующий php-код/js-код:

<?

if(geoip_country_name_by_name($_SERVER['REMOTE_ADDR']) != 'Russian Federation')

{

echo '<script>window.location.href = "https://www.google.com/";</script>';

} ?>

Я поставил себе такой скрипт на все страницы моего сайта и все боты не из России у меня пропали, а количество отказов значительно уменьшилось. Все сбрасывается на поисковик Google.

Кому еще будет плохо, кроме ботов?

Кроме иностранных ботов, в эту ловушку могут попасть и обычные люди, использующие VPN. Среди таких могут оказаться Ваши потенциальные клиенты. Тогда в этом случае, лучше скинуть не на GOOGLE, а создайте простейшую капчу у себя на сайте и перенаправляйте людей туда. Кто введет капчу, тот получит доступ к сайту. В противном случае - будет признан ботом.